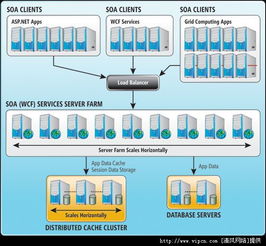

利用分布式缓存突破SOA可扩展性瓶颈 数据处理与存储支持服务的关键策略

在面向服务的架构(SOA)中,随着服务数量的增加和业务规模的扩大,系统常常会遇到可扩展性瓶颈,尤其是在数据处理和存储支持服务层面。这些瓶颈可能导致响应延迟、吞吐量下降,甚至服务不可用。为了解决这一问题,引入并有效运用分布式缓存已成为一项关键且高效的技巧。

一、SOA中的可扩展性挑战与缓存的作用

SOA的核心思想是通过松散耦合的、可重用的服务来构建应用。当这些服务频繁访问后端数据库或进行复杂计算以获取数据时,数据库往往成为瓶颈。每个服务请求都可能触发昂贵的I/O操作或重复计算,这不仅消耗资源,也限制了系统的水平扩展能力。

分布式缓存通过将频繁访问的数据存储在内存中,为SOA提供了一种高速数据访问层。它可以:

- 减轻数据库负载:缓存热点数据,减少直接数据库查询,从而降低数据库的并发压力和响应时间。

- 提升响应速度:内存访问速度远高于磁盘I/O,能显著加快服务的数据检索速度。

- 增强系统弹性:通过数据副本分布在多个节点,缓存层本身可以水平扩展,并在一部分节点故障时继续提供服务。

- 解耦服务与数据源:服务更依赖于缓存接口,降低了与特定数据库的紧耦合,便于技术栈演进。

二、利用分布式缓存处置数据处理瓶颈

对于数据处理密集型服务,缓存策略尤为关键:

- 缓存计算结果:对于耗时的聚合、转换或模型推断结果,可以将其缓存起来。后续相同参数的请求可直接返回缓存结果,避免重复计算。

- 缓存查询结果:将常见的数据库查询结果(如用户信息、产品目录)进行缓存。使用合适的键(如用户ID、查询条件哈希)来存储和检索。

- 实现缓存预热:在系统低峰期或启动时,主动将预估的热点数据加载到缓存中,避免高峰期的“冷启动”冲击。

- 处理数据一致性:这是核心挑战。需要根据业务容忍度,采用合适的策略,如设置合理的过期时间(TTL)、在数据更新时失效或更新缓存(如使用发布/订阅模式),或采用更复杂的一致性协议。

三、利用分布式缓存强化存储支持服务

存储支持服务(如统一的配置服务、会话存储、消息中间件支持)是SOA的基石,缓存能极大优化其性能:

- 配置中心缓存:微服务或服务组件所需的动态配置信息(如功能开关、连接参数)可以缓存在本地或近端缓存集群中,减少对中心配置服务器的频繁拉取,提升服务启动和运行时效率。

- 分布式会话存储:在无状态服务设计中,用户会话状态可以存储在如Redis或Memcached这类分布式缓存中,实现跨服务实例的会话共享,支持无缝的负载均衡和故障转移。

- 消息与事件缓存:在高吞吐量的异步通信场景中,缓存可以作为消息的临时缓冲区或事件日志的快速索引,加速下游服务的处理。

- 作为读写分离的补充:在“读写分离”架构中,缓存可以作为读库的强力补充,甚至承载绝大部分读流量,让主库和读库更专注于数据一致性和复杂查询。

四、实施关键技巧与最佳实践

- 选择合适的缓存产品:根据数据模型(键值、文档、图等)、一致性要求、持久化需求和社区生态,选择如Redis、Apache Ignite、Hazelcast或Memcached等。

- 设计合理的键结构:键的设计应具备可读性、唯一性和模式化,便于管理和清除。例如,使用

service:entity_type:id的格式。 - 实施多级缓存策略:结合本地缓存(如Guava Cache、Caffeine)和分布式缓存。本地缓存用于极热点数据,分布式缓存用于共享数据,形成高效的分层体系。

- 监控与治理:密切监控缓存的命中率、内存使用率、网络延迟等关键指标。建立缓存的标准化治理流程,包括容量规划、故障预案和定期清理。

- 容错与降级:设计当缓存集群不可用时,服务能自动降级至直接访问数据库,并保障核心功能的可用性,避免单点故障导致系统雪崩。

结论

在SOA架构中,有策略地议决(采用)分布式缓存,是解决可扩展性瓶颈,特别是数据处理和存储支持服务层面瓶颈的一剂良方。它通过将数据移至访问速度更快的存储层,有效分摊后端压力,提升整体系统吞吐量和响应能力。成功实施离不开精心的数据一致性设计、合理的架构选型以及持续的监控优化。将分布式缓存深度集成到SOA的数据访问模式中,能够为构建高性能、高可用的分布式系统提供坚实的支撑。

如若转载,请注明出处:http://www.zhaocebao.com/product/37.html

更新时间:2026-02-28 13:41:09